Entrevistas

3 de Junio de 2023Tomás Pérez-Acle, experto en Inteligencia Artificial: “Es una tecnología que nos supera en lo que la bondad o la maldad es capaz de manejar”

Biólogo y doctorado en Biotecnología, Tomás Pérez-Acle aborda las alarmas que se han encendido frente al desarrollo acelerado de la Inteligencia Artificial. Director de un centro basal de investigación científica, explica que vivimos un cambio paradigmático, pero advierte que es solo el inicio, porque la verdadera IA, que es aquella que tiene conciencia de sí misma, no existe todavía. “No vamos a reconocer el mundo y nuestros tomadores de decisiones tienen que saberlo”, afirma. En el caso de Chile, define como urgente tener “una política de datos” porque “sin datos no existe inteligencia artificial”.

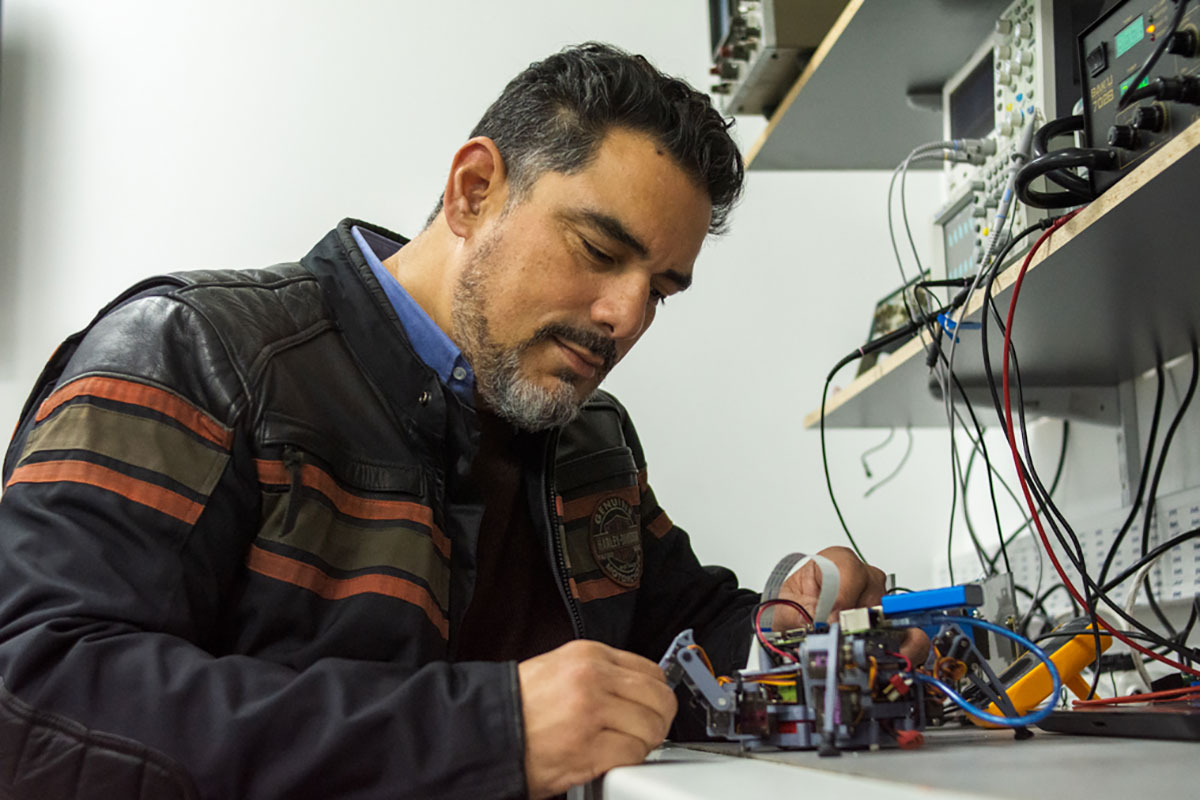

Es viernes y el biólogo y experto en Inteligencia Artificial, Tomás Orlando Pérez-Acle (52), desplaza su metro noventa de altura por los pasillos semi vacíos de la Fundación Ciencia & Vida. El viernes es el día en que los 200 funcionarios de este centro dedicado a la investigación ejercen el teletrabajo.

Mientras avanza debajo de una pesada chaqueta de motoquero –“es que soy harlista”, dirá en algún momento- saluda a sus escasos interlocutores, mientras parece pasar revista. Pregunta por facturas, por informes, por avances en la reforma que está en desarrollo en el subterráneo: “Aquí va a funcionar el súper computador más potente del país”, exclama a la vez que hace el quite a cables y procesadores viejos.

Desde la calle es imposible imaginar que dentro de ese edificio cuadrado de cinco pisos en la Ciudad Empresarial capitalina están empezando a integrarse las cinco áreas operativas de esta institución. Según expresa su sitio web, Ciencia & Vida es una entidad privada y sin fines de lucro que orienta sus esfuerzos a “mejorar el desarrollo social y económico de Chile a través del descubrimiento científico, el emprendimiento y la educación en ciencias biológicas”.

Creada en 1996 por el bioquímico y Premio Nacional de Ciencias Aplicadas y Tecnológicas de 2002, Pablo Valenzuela, es un centro basal que recibe financiamiento del Estado chileno y de privados. Uno de sus clusters está dedicado al cáncer. Otro, en el que Pérez-Acle trabaja como investigador, está orientado a la biología computacional. Él es, además de profesor en la Universidad San Sebastián y en el Centro Interdisciplinario de Neurociencia de Valparaíso, el director de Ciencia & Vida: “Somos 12 investigadores principales y 18 investigadores asociados”, explica.

Pérez-Acle es biólogo y doctorado en Biotecnología. Su currículum tiene -entre otras- validaciones en biotecnología, bioinformática, genética, programación y computación de alto rendimiento (HPC), que es la que usa los computadores para resolver problemas complejos en ciencia, ingeniería y gestión. En pocas palabras podría decirse que vive, come y respira alrededor de los computadores, la programación, los algoritmos y la simulación. Es un experto en inteligencia artificial (IA).

– ¿Y cómo describiría qué es la IA?

Sentado en una robusta silla gamer con toques anaranjados, Pérez-Acle se toma un segundo y luego afirma con completa tranquilidad:

“Lo primero que hay que definir es que la inteligencia artificial no existe todavía. Es un gran anhelo de los científicos que trabajamos en el área. Eventualmente, vamos a tener una máquina que, bajo cualquier definición, podremos catalogar como inteligente. Existen múltiples definiciones, pero me gusta la de una entidad que tiene la capacidad de resolver, de una manera novedosa, un problema que no ha visto previamente”.

Pérez-Acle explica que hoy los computadores son máquinas entrenadas para resolver problemas vistos muchas veces: “Es lo que se llama el entrenamiento o el aprendizaje de máquinas”, afirma. Un computador de los que hoy se denominan inteligentes ha recibido millones de datos y millones de resultados posibles para la solución de un solo problema.

“Se le enseña, por ejemplo, a reconocer caras de humanos, pasándole miles de millones de caras de humanos. Cuando llega una cara, por muy distinta que sea, más gordo, más flaco, más chico, la va a reconocer porque ha visto miles de millones. Pero no está resolviendo el problema de manera innovadora, porque está entrenado para ver caras. Si a ese computador le decimos: “Ya que conoces caras de humanos, ahora reconoce la cara de un elefante o de un perro”, lo más probable es que no podrá hacerlo. Sólo lo hará si antes también lo hemos entrenado para eso.

-¿Por qué, entonces, parecemos tenerle tanto miedo a la IA?

-Porque hay una construcción popular sobre la IA que ha sido establecida por Hollywood. En la ciencia ficción nos damos cuenta de que los seres humanos somos malignos para el planeta, lo estamos destruyendo. Tenemos eso en el inconsciente y entendemos que, eventualmente, si existe una especie de ser superior, porque dotamos a los robots y a estas IA de una definición de ser superior, este ser superior ve que si quiere salvar el planeta, el fin último es destruir a los humanos.

El lado lindo de la IA

Junto a su equipo, Tomás Pérez-Acle se dedica principalmente a usar herramientas computacionales para modelar fenómenos biológicos en distintas escalas. Abordan, por ejemplo, lo que ocurre al interior de una célula: “Modelamos cómo es posible que dos neuronas se comuniquen entre ellas a través del impulso nervioso. Y eso lo hacemos con computadores con tecnologías que dieron lugar al Premio Nobel en 2013”.

¿Para qué sirve un ejercicio teórico de conversación entre células? Por ejemplo, para comprender cómo cambios en el material genético producen una enfermedad: “Si entiendes el efecto de ese cambio y cómo una señal que está fuera de la célula se traduce al interior, entonces eventualmente podrías diseñar una droga, nuevamente por métodos computacionales, para evitar el desarrollo de una enfermedad”.

Pérez-Acle cuenta que entre los financistas de Ciencia & Vida está la Oficina de Investigación de la Fuerza Aérea Norteamericana: “Si uno rankea la plata que se invierte en ciencia y tecnología en Estados Unidos, ve que la primera entidad es la Fundación Nacional de Ciencia, la segunda es el Instituto Nacional de Salud y el tercero son las oficinas de investigación de las ramas de las FF.AA. En el caso de la Fuerza Aérea, el 30% de su presupuesto de investigación se destina a investigación extramural. ¿Por qué esa oficina va a financiar ciencia afuera de Estados Unidos? Bueno, porque todo el conocimiento que ellos generan los nutre de capacidades para enfrentar lo que se venga en el futuro”.

-¿Qué uso beneficioso está dándonos y que puede llegar a darnos la IA?

-Los ámbitos son prácticamente inagotables. Nosotros, por ejemplo, estamos desarrollando un proyecto con una empresa chilena que hace electrocardiografía remota. A los pacientes que van a los Cesfam les conectan los electrodos y la señal se transmite centralizadamente. Aquí, los médicos se conectan a los sistemas y evalúan si el examen está o no correcto y hacen el diagnóstico. Hoy día, un médico se demora entre 10 y 15 minutos en hacer una evaluación, pero la persona está con un infarto 10 minutos pueden ser de vida o la muerte. Si aplicamos métodos de IA no para reemplazar sino para apoyar el diagnóstico y la toma de decisión del médico, entonces somos capaces apoyar para salvar vidas.

-Y sin duda hay más, ¿verdad?

-La IA se puede aplicar para imágenes satelitales de reconocimiento de lugares para enfocar planes contra la sequía y el cambio climático. Se puede utilizar para mejorar el tránsito de las calles, para mejorar las capacidades en robótica, para crear nuevos métodos de enseñanza y tener los tutores digitales, uno para cada niño. Yo me atrevería a decir, sin exagerar, que son realmente infinitas y que no somos capaces de visualizar. Pero hoy, en las aplicaciones y los beneficios por lejos superan a cualquiera de los mal usos.

El lado oscuro de la IA

El mal uso es, sin embargo, lo que trae de cabeza en este momento a los observadores. La IA está proponiendo un cambio de paradigma en el mundo y estandarte son los programas que trabajan sobre modelos de lenguaje, como ChatGPT. Pérez-Acle afirma que además de ser “un negocio increíble” y “es la primera aplicación que llega a 100 millones de usuarios en un mes”.

ChatGPT fue creado al alero de la organización sin fines de lucro OpenAI Incorporated. Sus eventuales usos insospechados y la alarma que eso provoca se ven reflejados en una carta abierta promovida por la ONG norteamericana Future of Life Institute, publicada el 12 de abril. El pide una moratoria de seis meses en el desarrollo de la IA, dado el potencial peligro que representaría para la Humanidad. Lo impactante de ese llamado son sus firmantes. Entre el millar de personas están Yoshua Bengio, uno de los tres padrinos de la IA, y Elon Musk, actual dueño de Twitter y cofundador de OpenAI.

-En este momento llamamos IA a algo que todavía no lo es, pero sabemos que la IA está acerca. ¿Qué va a pasar cuando lo logremos?

-En ese minuto se va a producir la singularidad que, en términos de computación, es cuando emerge una IA capaz de engañarnos, que piensa por sí sola. Pero lo relevante no es que sea inteligente y pueda demostrar su inteligencia, sino que además tenga conciencia de sí misma. Tengo la impresión de que es eso a lo que le tenemos un poquito de terror, porque desarrollamos una entidad inteligente que no depende de nosotros, sino que es una especie de otro, un interlocutor que te puede juzgar.

-Y si tiene la ética humana nos puede fregar la vida, porque puede ser mala, ¿no?

-Claro. Efectivamente podría ser mala. Pero también podría ser buena, podría juzgarnos desde la benevolencia. Podría darse cuenta de que los seres humanos somos un desastre, y de ahí ese temor que tenemos de que venga alguien y nos juzgue en nuestra imperfección humana. Cuando tenemos una entidad que es aparentemente superior, y que es esta singularidad, no sabemos si va a ser suficientemente benevolente para perdonar nuestros errores constantes y consistentes, en vez de alabar nuestras virtudes.

-Si tomamos la lógica hollywoodense, es cuando aparece la Matrix, que de alguna manera nos controla y considera que los humanos somos un virus despreciable.

-Existen referencias muy anteriores a esa, particularmente en la ciencia ficción de los años 50 y 60 del siglo XX, que era muy mala en términos técnicos pero que, desde el punto de vista de los conceptos, ya tiene la gracia de crear computadores conscientes. Nosotros creemos que va a venir esta inteligencia artificial a juzgarnos, y ése es el gran problema. Es increíble. Al tenerle miedo al juicio, reconocemos que somos un desastre para el planeta y que no hacemos todo lo que debiéramos hacer para protegerlo.

-Nuestro conflicto parece ir más allá de la máquina y es ético. ¿Qué podemos hacer, desde la ética, frente a las máquinas o a la IA?

-Siempre se ha dicho, en el ámbito científico, que la ciencia es amoral. Eso significa que la moralidad y la ciencia corren por carreteras separadas. Cuando uno reviste de moral a la ciencia es cuando la ciencia está en peligro. Hay que abstraerse de la moral, para que el conocimiento científico sea lo más puro posible. Distinto es con son sus aplicaciones. Las aplicaciones del conocimiento científico pueden tener consecuencias muy benevolentes o muy terribles.

-La bomba atómica es un clásico ejemplo de eso.

-Cuando Einstein desarrolla la Teoría General de la Relatividad llega a esta ecuación maravillosa, que es energía igual a materia al cuadrado (E = mc2). Es una ecuación increíble, que dice la energía y la materia son lo mismo y que explica, entre otras cosas, por qué la energía y la materia nunca se crean ni se destruyen, sino que solo se transforman. Por lo tanto, ésa es una ecuación fundamental y está puesta en poleras por todas partes del mundo. Pero también cambia el mundo, si va alguien y a esta ecuación le pone un delta, que quiere decir que si yo produzco un rompimiento en la masa o una variación de la masa libero una enorme energía, porque eso es una bomba.

-Ese es Oppenheimer, ¿no?

-Sí. Pero no se trata sólo de Robert Oppenheimer. Él estaba compitiendo con los nazis y hay todo un debate ético súper interesante, porque los nazis estaban produciendo la bomba atómica. Entonces era quién llegaba primero para el control del mundo.

-Entonces es la aplicación del conocimiento científico la que debe revestirse de moralidad. Si podemos cambiar esa palabra por neutralidad, habría que decir que el desarrollo es neutro, pero su aplicación no debiera serlo.

-Es cierto. A aquellos que desarrollaron las redes atencionales no los podemos culpar de que, eventualmente, emerja una inteligencia artificial que nos llegue a juzgar y a acabar con nosotros. Lo que tenemos que hacer es preocuparnos de cómo establecemos hoy día los lineamientos generales para que los desarrollos en IA vengan revestidos de aquellos elementos de moralidad que son necesarios”.

-¿Qué es lo que desde su perspectiva debiéramos hacer? ¿Hay líneas de acción por donde debiéramos circular?

-Hay varias líneas, pero la primera es que tenemos que entender lo que estamos viviendo. Tiene que haber un cambio dramático, paradigmático, en el currículum y no solamente en educación superior, sino también en educación básica y en educación media. Hace rato que venimos con el discurso de tener capacidades para interactuar con el mundo digital, pero ahora es aún más relevante. Hoy, aquellos que somos capaces de usar las herramientas que ofrecen estas tecnologías de IA tenemos ventajas sobre aquellos que no son capaces de usarlas.

Aquí en el laboratorio el uso de estas herramientas nos ha producido un boost (incremento) de energía, de capacidad, de generación. Hoy día, yo soy muchísimo más productivo de lo que era antes. Entonces, la pregunta es: ¿qué hago con esa mayor productividad? ¿Trabajo más horas para obtener más resultados? ¿O a lo mejor podría trabajar menos horas llegando a los mismos resultados?”.

Tarea para legisladores y usuarios de la IA

Expertos como Pérez-Acle creen hoy que la mejor forma de enfrentar lo que se nos viene con las IA es empezar a discutirlo. Hay que aprender a usar y, más que eso, saber cómo se usa y por qué se usa como se usa. También sostienen que es necesario crear regulación para acotar, aunque esa no es la panacea: “Si nosotros cerramos los ojos, creyendo que las leyes van a solucionarlo todo, y no nos preocupamos de que nuestra gente, nuestros niños, entiendan qué significa esto, cómo se usa bien y cómo se puede mal usar, malamente vamos a poder generar legislación para evitar el mal uso.

-Parece haber desafío ético y de acceso a la educación.

-Sí, por cierto. Y la educación tiene que ir más allá de la escuela o del nivel de la audiencia, debe llegar a los tomadores de decisiones. Estas tecnologías llegaron para quedarse. Van a seguir metiéndose en nuestra vida diaria y no nos vamos a dar ni cuenta. En 10 años no vamos a reconocer el mundo, y nuestros tomadores de decisiones tienen que saberlo, asimilarlo.

Dentro de la legislación, Chile ha sido bastante avizor, promoviendo leyes como la de neuroderechos. Pero en políticas de Inteligencia Artificial nos hemos equivocado. Hemos puesto la carretera delante de los bueyes, porque no tenemos una política de datos y sin datos no existe inteligencia artificial y no existe la ley de neuroderechos.

-Es decir, estamos atrasados.

-Pero vamos en la línea correcta y, de hecho, más rápido que algunos países más desarrollados. Es muy importante entender que, cualquier cosa que vayamos a proteger desde el punto de vista legislativo, seguramente va a quedar obsoleto en los próximos años. Lo que veremos será tan paradigmático que va a cambiar el mundo. Por lo tanto, hay que estar preparados para enfrentar ese nuevo mundo y también para reaccionar rápidamente. Debemos ir tan rápido como va ese nuevo mundo o lo más rápido posible, lo cual significa que va a ser imposible juzgar y legislar para todos los casos.

-Pero es importante tener una regulación. ¿Lo recomienda?

-El marco regulatorio, entre otras cosas, debería preocuparse no solamente de los que ejecutan y hacen estos desarrollos, sino más bien de los que hacen sus aplicaciones. Hay algún tipo de aplicación que, en mi juicio, debería estar restringida, bajo una mirada más atenta.

Por ejemplo, aquellas aplicaciones que pudieran utilizarse en el contexto de producir fake news. Eso es un grave problema hoy día. Tenemos una situación bien compleja en la abundancia de la desinformación. En todas las desinformaciones siempre hay alguien que gana algo, hay alguien que gana poder, hay alguien que gana dinero o habitualmente ambas cosas. Por lo tanto, estas nuevas herramientas pueden ser utilizadas perfectamente para producir desinformación.

-¿La regulación debe ser global?

-Hay un desafío en los distintos tipos de sociedad y modelos sociales que tenemos en el mundo. Nosotros tendemos a ver el mundo desde el occidentalismo y creemos que todo el mundo es occidental. Pero basta darse una vuelta en Asia o en India y te das cuenta de que es un mundo completamente distinto. Entonces ahí se hace súper difícil llegar a mínimos y lo más importante es llegar a mínimos comunes entre las distintas sociedades, tal que a partir de ellos pueden establecerse legislaciones.

-¿Y castigar el mal uso de estas tecnologías?

-De nuevo, va a ser imposible ponerse en todos los ámbitos, tal que podamos legislar caso a caso.

– ¿Qué cosas se pueden hacer?

-Es mucho más fácil legislar las cosas que no se pueden hacer. Hay aquellas cosas que no podríamos permitir.

-¿Se le ocurre algún ejemplo?

-De nuevo, las fake news. El caso más emblemático lo tenemos con las elecciones en que salió el presidente Donald Trump en Estados Unidos y esta gran empresa (Cambridge Analytica), que utilizó las redes sociales para influir a partir de algoritmos de Inteligencia Artificial que están hoy día corriendo, y lo hacen desde hace mucho rato, en las redes sociales. Eso es problemático porque no solamente somos capaces de influenciar a las personas bombardeándolas con publicidad engañosa. En las redes sociales estos mismos algoritmos de IA están provocando una separación de la sociedad como no habíamos enfrentado antes.

Llamando a la transparencia en la Inteligencia Artificial

Hay dos graves problemas morales y a la vez prácticos a los que nos enfrentamos los usuarios de redes sociales. Ambos son fenómenos provocados por la selectividad de los algoritmos. Uno es que producimos la llamada “cámara de eco digital”: al seleccionar, conseguimos que todo el mundo opine y piense como nosotros. Lo segundo, que es consecuencia de lo primero, es que se produce un “sesgo de confirmación”: al ver que “todo el mundo piensa igual” creemos que estamos en lo correcto y se agudiza la polarización.

Cuando eso pasa, a pesar de que hoy en la Tierra hay 8.000 millones de personas, pareciera que el mundo es un pañuelo, nos aislamos. Pérez-Acle dice: “Achico tanto el mundo, que termino creyendo en teorías conspiracionistas y creo que la Tierra es plana y que las vacunas son una cuestión que arregló (el multimillonario) George Soros para acabar con el mundo, y que estamos llenos de nanochips con 5G en el cuerpo, cuando en realidad el 5G lo tenemos en el bolsillo y nos empaqueta hasta el plato que compramos. Si permitimos que las IA sean utilizadas en ese contexto y sin el castigo apropiado, nos vamos a enfrentar a una realidad en la que no tenemos idea de lo que puede llegar a ocurrir”.

-En términos de regulación global, ¿qué hacemos con países opacos como China?

-Hay que considerar que, en muchos aspectos, los chinos son bastante más avanzados que nosotros. Son una sociedad mucho más controlada, pero también donde el bien común está muy por sobre el individual, incluso a veces en la exageración. Particularmente, en legislación, China tiene hace mucho rato sistemas de castigo y recompensa a los ciudadanos a partir de IA que están en las calles, por ejemplo, detectando comportamiento inadecuado. No quiero decir que esto sea lo correcto, pero no hay que demonizar a China en estos aspectos.

También es cierto que existe la opacidad desde el punto de vista de la comunicación y se entiende que esa opacidad requiere de algún tipo de conversación y de llegar a estos mínimos comunes. Creo que los mínimos comunes son interesantes. Y pasa también con India. La gente tiende a verlo como un lugar extremadamente pobre, pero existe una gran capacidad de desarrollo tecnológico. En Bangalore, que es como el California de India, grandes corporaciones hacen todo su desarrollo de software.

-Porque les sale más barato.

-Y porque en India tienen programadores de muy buen nivel. Hay que tener en consideración que, si buscamos que todo el mundo piense como nosotros, estamos equivocados.

-En los mínimos comunes y la opacidad también pasa que los verdaderos desarrolladores son opacos y muy pocos.

-Hoy, en el ámbito de los modelos de lenguaje, como ChatGPT, que son estos estos desarrollos que están moviendo la aguja, porque están produciendo cambios paradigmáticos, son cuatro. Estamos hablando de Google, de Facebook, de OpenAI y de Microsoft, que está metido también. Ellos están llevando adelante los cambios y el resto somos nada más que observadores y eventualmente beneficiarios de lo que ellos hacen. Pero también podríamos vernos afectados.

Quienes hoy día somos capaces de usar esta herramienta en nuestro propio beneficio para mejorar nuestra capacidad laboral vamos a ser capaces de sobrepasar a aquellos que no lo hagan. Entonces se está de nuevo produciendo una separación. Siempre ha ocurrido. Ocurrió con la calculadora, el teléfono celular o el computador. Lo que pasa es que ahora es que hay un cambio paradigmático y ahora legislar a estos cuatro grandes es muy difícil.

-Siguiendo con la lógica de “los grandes”, de la impresión de que el paso al costado que da Geoffrey Hinton al salir de Google levanta las grandes. Él es uno de los padres de la Intelgencia Artificial y dice que todo va demasiado rápido.

-Sí, pero no es el primero. En la carta moratoria ya estaba Yoshua Bengio, que es uno de los próceres de la Inteligencia Artificial. Hinton es el primero que da el paso al costado. Ellos saben que hay que preocuparse de lo que está pasando. Y nosotros sabemos que no estamos a la altura, que estamos desarrollando una tecnología que nos supera en capacidad de lo que la bondad o la maldad es capaz de manejar.

-¿Existe alguna posibilidad de que la singularidad ya haya ocurrido y que no lo sepamos?

-No, es muy difícil. Va a ser algo tan dramático, tan relevante, que no que no va a ser posible ocultarlo.

Tres recomendaciones

Tomás Pérez-Acle se define como un “ñoño”. Le encanta la ciencia ficción, sabe de películas y de libros. Cuenta, por ejemplo, que llama Hal 9000, el supercomputador del filme “2001, una odisea del espacio” se llama así por la firma tecnológica norteamericana IBM: “una letra antes H por I, A por B, L por M”. Estas son sus tres autores recomendados:

1) Isaac Asimov, de todas maneras. Es para aquellos que quieran entender la robótica y la inteligencia artificial desde una mirada más humana. Recomiendo “Yo, Robot”.

2) Arthur Clarke, que nos pone una visión un poco más terrible a partir de Odisea del Espacio en 2001 y 2010.

3) Frank Herbert que, para mi gusto, es el autor más relevante de la ciencia ficción de toda la historia. Con “Duna” plantea un escenario absolutamente post apocalíptico y post inteligencia artificial. La Inteligencia Artificial se rebeló contra los humanos, pero los humanos son capaces de superarse y ganarle a la inteligencia artificial a partir de un desastre.